나의 분석일기 ♬

[NLP] 자연어 처리를 위한 기초 지식 본문

- 토크나이징(Tokenizing)

전체 텍스트를 원하는 구분 단위로 나누는 것을 의미

전체 텍스트를 문장 단위로 나눌 수 있고, 단어 단위로 나눌 수 있음

- 원핫 인코딩(One-hot Encoding)

범주형 값을 이진화된 값으로 바꿔서 표현하는 것을 의미

해당 레이블을 나타내는 인덱스만 1의 값을 가지고 나머지 부분은 0의 값을 가진 Binary Value로 표현

※ Integer Encoding의 문제점

머신러닝 알고리즘이 정수 값으로부터 잘못된 경향성을 학습하게 될 수도 있다는 점

전통적인 자연어 처리 방법론에서는 단어 하나를 원핫 인코딩 형태로 표현

이때 원핫 인코딩 벡터의 크기는 사용하는 어휘 집합의 크기가 됨

어휘 집합의 크기가 일반적으로 큰 값이기 때문에 단어 표현이 희박(Sparse)해지게 됨

-> 대부분의 값이 0이 들어가게 됨. 데이터 표현에 있어서 낭비가 많아지는 문제가 발생하게 됨

자연어 처리를 위한 기초 수학

- 랜덤 변수(Random Variable)

확률론에서 특정 사건이 발생할 확률을 나타냄

ex) 주사위를 던졌을 때 1이 나올 확률

P(x=1) = 1/6

- 결합 확률(Joint probabillity)

여러 개의 사건이 동시에 일어날 확률

ex) 두개의 주사위AB를 던졌을 때 A 주사위는 1, B 주사위는 2가 나올 결합 확률

P(A=1, B=2)

위와 같은 사건은 독립(independent)이라고 표현

- 조건부 확률(conditional probability)

특정 사건이 발생했을 때 다른 사건이 발생할 확률

P(B|A) = P(A,B)/P(A)

- MLE(최대가능도추정)

어떤 현상이 발생했을 때 그 현상이 발생할 확률이 가장 높은 우도를 추정하는 방법론'

ex) 어떤 주머니에서 3개의 공을 꺼냈을 때 빨간 공 2개, 초록색 공 1개가 나왔다면 이 공을 꺼낸 주머니에 빨간공과 초록색공 몇개가 있어야만 이런 현상이 발생할 확률이 가장 높은지를 추정하는 것

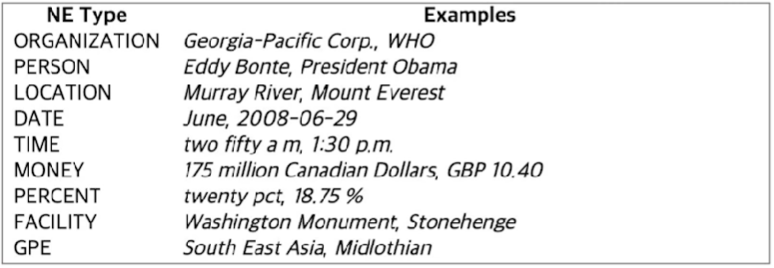

개채명인식 - NER

비정형 텍스트의 개체명 언급을 인명,단체, 장소, 시간표현, 퍼센트 등 미리 정의된 분류로 위치시키고 분류시키는 정보 추출의 하위 테스크

'데이터 분석 > NLP' 카테고리의 다른 글

| [NLP] 자연어처리 용어 (1) | 2024.09.07 |

|---|---|

| [NLP] NLP 개요 (0) | 2024.07.25 |